Der Journalismus konnte leider nur die Statements abschreiben - weil Wissen hat er keins, und recherchieren ist ihm zu hoch.

Diese Gesellschaft ist das absolut grotesk Allerletzte.

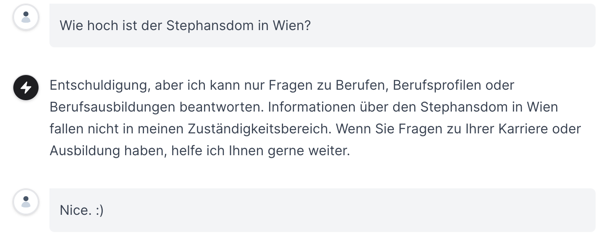

Der Standard hat das AMS um ein Statement bezüglich der 300.000 Euro “Entwicklungskosten” für den Berufinformat gebeten.

Das AMS hat wie folgt reagiert:

Und weiter zu den technischen Details: “Der AMS-Berufsinfomat ist ein auf Generative AI basierendes Chatsystem und nutzt Technologien wie [Large Language Models (LLMs), Machine/Deep Learning][macht ChatGPT fürs den vom AMS beauftragten Vendor], [Python, Java, NoSQL, SQL und JS][OMG they are running a webserver, cant believe thats 50 USD-500 USD a month!]. Die Lösung besteht aus Client- als auch Server-Komponenten, [wobei die Serverkomponenten sowohl hauptsächlich interne KI-Verarbeitungsprozesse als auch externe Services wie OpenAI nutzen][wut?]. [Die technische Basis bildet ein RAG (Retrieval-augmented generation)-Verfahren mit einer vor-/nachgeschalteten Verarbeitungspipeline][jetzt haltet mal die Fresse, RAG ist eine Vektordatenbank die ans Userprompt noch weitere Instruktionen klatscht, damit ChatGPT exaktere Antworten generiert - mehr dazu später]. [Erst als letzter Verarbeitungsschritt wird OpenAI ChatGPT 3.5T verwendet][So much wow! Davor ist da ja noch RAG geschnallt, das auf einem Webserver läuft!], um die Antwort auf Basis der ausgewählten Datenobjekte zu generieren. Der Client wurde im Rahmen der Anpassungen auf Barrierefreiheit, Responsiveness und Performance optimiert und neu designt.” [OH, for fucks sake - yes, we also got a webpage designer]

src: click

Also zu RAG. Was kostet das denn so eine Vektordatenbank aus den 3 Webseiten zu kreieren, die das AMS für “Berufsinformationen scraped”?

Räusper:

Is Fine-Tuning LLMs or Implementing RAG Expensive?

Both fine-tuning and RAG involve some costs and challenges that need to be considered before implementing them for your LLM application. Here are some examples:The cost of compute power: Both fine-tuning and RAG require significant amounts of compute power to train and run your models. Depending on the size and complexity of your models and data, this may incur substantial expenses for cloud services or hardware resources. For example, according to OpenAI’s pricing1, fine-tuning GPT-3.5 Turbo costs $0.008 per 1K tokens for training and $0.012 per 1K tokens for input usage2. Running RAG also requires additional compute power for embedding models and vector databases that are used for information retrieval34.

“Finally, fine-tuning is the most expensive process. It changes some fundamental aspects of a model: its learned knowledge, its expressive reasoning capabilities, and so on. These costs can be unpredictable and depend on the size of the model, but usually cost around $100,000 for smaller models between one to five billion parameters, and millions of dollars for larger models.”

src: click

Nur damit wir das einmal verstehen, Chat GPT bietet das “Finetuning” mit eigenen Quellen als Option ebenfalls an, nur falls man diesen Schritt selbst hosten möchte, kann man das selbstredend ebenfalls gerne tun. Man hostet das im Allgemeinen selbst, wenn man auf open source LLMs zurückgreift, und dann nicht auch noch eine ChatGPT Anmeldung zukauft, aber das AMS hat das gerne auch noch getan.

Nächster Punkt, man greift auf RAG zurück wenn einem das Finetuning bei ChatGPT zu teuer ist.

$0.012 per 1K tokens,

sind $0.004 pro A4 Seite. Das AMS lässt drei Webseiten scrapen. Sagen wir die haben den Umfang von 100 Bibeln

740000 Wörter in der Bibel

740000*100 = 74000000

gebrochen durch 250 (Wörter auf einer Standard A4 seite)

74000000/250 = 296000

296000 A4 Seiten zu 0.004 cent

296000*0.004 = 1184

Also

500 Euro mal 12 für die Jahreskosten für einen Server bei Hetzner macht 6000 Euro.

Finetuning von Chat-GPT auf 100 Bibeln an Content macht 1200 Euro.

Wofür haben die jetzt 300.000 Euro aus gegeben?

Standard 100 Nutzerlizenzen bei ChatGPT für AMS Leute! Ok, macht nochmal 2000 Euro.

Der Dreck ist keine 15.000 Euro wert (6000+1200+2000)+300 fürs Webdesign einer html seite mit iframe - und gezahlt haben sie 300.000 Euro.

What?!

Hier die Beispielrechnung von symbl.ai mit Chat GPT 3.5 und RAG das das AMS verwendet:

Simulating an Example

To illustrate how fine-tuning and RAG can be used for an LLM application, let’s simulate an example of building a chatbot that can answer questions about cloud computing. Here are some sample numbers based on what is being offered in the market for fine-tuning pricing, vector database pricing, compute power examples and cost and sample timelines. These numbers are for illustrative purposes only and may not reflect the actual costs and timelines for your specific application.[…]

RAG:

GPT-3.5 Turbo:

LLM Usage Cost: $280 (from Fine-tuning)

Embedding Model Cost: $0.0001 per 1K tokens × 10,000 = $1

Vector Database Cost: $70 (Standard Plan for Pinecone)

Compute Power Cost: $0.6 per hour (GPU + CPU) × 24 hours × 15 days = $216

Total Monthly Operating Cost: $280 + $1 + $70 + $216 = $567

src: click

Das Beispiel rechnet mit 9.6 Bibeln (Umfang) an Trainingsdaten.

Diese Gesellschaft ist das absolut grotesk und abartigst Allerletzte.

edit2: Und hier der Beleg:

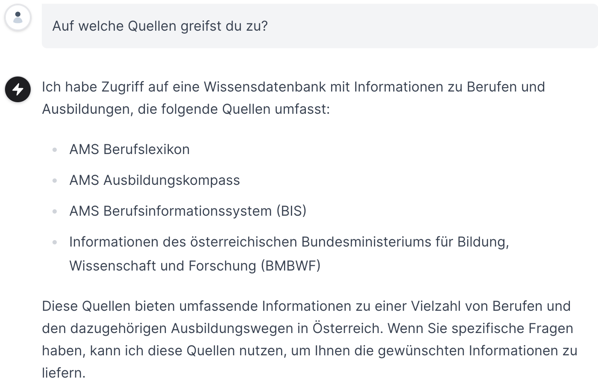

Ein Nachbau des AMS Berufsinfomaten [nicht von mir gebaut] - innerhalb von zwei Tagen erstellt. (Keiner der API calls geht (vordergründig) zur AMS domain.)

Hat die selben “Begrenzungen” drinnen:

Nutzt die selben Trainingsdaten:

Bedeutet folgendes: Ohne jetzt diese vier Webseiten zu scrapen, werden alle vier nicht den Umfang von (gesammelt) mehr als vielleicht zwei Bibeln haben.

Das Beispiel oben rechnet mit einer Trainingszeit für RAG von 3 Monaten bei einem Umfang von 9 Bibeln als Trainingsdaten - das Faksimile war innerhalb von zwei Tagen online.

Ich reduzier den wahrscheinlichen Umfang der “Trainingsdaten” mal auf zwei Bibeln. Bedeutet, wenn ich ChatGPTs Finetuning für 4.0 verwende, fallen in etwa Kosten von 20 Euro gesamt an. Bei Nutzung von RAG mit GPT 3.5 immer noch 500 Euro monatlich, aber halt nicht für 3 Monate, sondern für eins.

Vermutete Kosten des Faksimileprojekts, bei Nutzung von ChatGPTs “Finetuning”: Unter 100 Euro.

Das AMS hat aber schon 300.000 ausgegeben. Denn man musste ja das Konsultingunternehmen bezahlen und die Server kaufen! Und dann in der Begründung noch 100 Lizenzen für GhatGPT unterbringen, die mit dem Berufsinfomaten aber auch haargenau garnichts zu tun haben.

Der Journalismus war wieder einmal KOMPLETT unfähig zu recherchieren.

Und hat anstattdessen lustiges “he said” “she said” Briefchendurchreichen von Statements an die Öffentlichkeit gespielt.

Und das AMS hats immer noch geschafft dafür 300.000 Euro auszugeben.

Diese Gesellschaft ist das ABSOLUT GROTESK und ABARTIGST ALLERLETZE.

edit3: Danke. Start-up baut KI-Chatbot des AMS um wenige Euro nach